一 本文概要

传统的递归神经网络(RNN)架构,如LSTM和GRU,在时间序列任务中一直很流行。然而由于存在长期依赖难以建模,梯度不稳定,计算效率低等局限性,最近的时间序列预测研究已经不再集中在RNN上,而是转向了其他架构,比如Transformer、MLP和CNN等。为了解决传统RNN的局限性,本文设计了一种名为RWKV-TS的高效RNN模型,它有三个独特的特点:(i)一种新的RNN架构,它的时间复杂度和内存使用都比较低。(ii)相较于传统RNN,它能更好地捕捉长期序列信息。(iii)它具有高计算效率和良好的可扩展性。通过大量实验证明RWKV-TS模型在与基于Transformer或CNN的最先进模型进行比较时表现出了很好的性能。

二 背景知识

时间序列分析是机器学习中的一个基础领域,具有广泛的应用,从金融预测到环境预测。历史上,传统的循环神经网络(RNN)由于其捕捉时间依赖关系的固有能力,一直是建模序列数据的基石。然而,最近传统的RNN在时间序列任务中逐渐失去了主导地位,时间序列的排行榜也被Transformer、多层感知器(MLP)和卷积神经网络(CNN)等替代架构所取代。传统的循环神经网络(RNN),无论是其原始形式还是像长短期记忆(LSTM)和门控循环单元(GRU)等变体形式,都存在以下限制:

-

梯度消失/爆炸问题限制了捕捉长序列中的信息能力。当序列长度超过100时,捕捉信息的能力迅速减弱。 -

无法进行并行计算导致计算效率低下,阻碍了扩展能力。 -

逐步预测的方法导致误差累积和推理速度较慢。

最近的研究表明,在处理时间序列任务时,Transformer模型和CNN模型都取得了显著的进展。Transformer模型通过并行化和注意力机制,能够高效处理序列数据,特别适用于长期时间序列预测任务。而CNN模型则擅长提取时间数据中的局部模式和特征,在各个时间序列领域都展现了优异的结果。已经提出了一些基于Transformer的模型,如LogTrans、Informer、Autoformer、FEDformer和Pyraformer等,它们通过不同的方法和技术来提高长期时间序列预测的效果。另一方面,基于多层感知机(MLP)的模型在时间序列预测中也得到了广泛应用。最近,一种名为DLinear的简单方法通过添加一个线性层和一种通道不可知策略,超越了基于Transformer的模型。这引发了关于是否需要使用复杂的Transformer模型进行时间序列预测的讨论。基于CNN的模型也在时间序列领域取得了显著的成果。一些基于CNN的模型,如MICN、TimesNet和SCINet,在长期时间序列预测领域展示出了令人印象深刻的结果。

三 本文贡献

本文主要介绍了一种名为RWKV-TS的高效RNN模型,用于处理时间序列任务。与传统的RNN模型相比,RWKV-TS具有以下三个关键特点:

-

新颖的RNN架构:RWKV-TS采用了一种新颖的RNN架构,具有较低的时间复杂度和内存使用量,使其在处理长序列数据时能够更好地捕捉到长期的依赖关系。 -

更好的长期序列信息捕捉能力:相较于传统RNN,RWKV-TS在捕捉长期序列信息方面表现更出色,能够处理包含长期依赖关系的时间序列任务。 -

高计算效率和可扩展性:RWKV-TS具有高计算效率,能够并行计算,从而提高了处理时间序列任务的效率,同时也具备良好的可扩展性。

通过对比实验,本文证明了RNN模型在处理时间序列任务时具有巨大的潜力。RWKV-TS的成功表明,通过改进RNN架构和优化计算效率,RNN模型仍然可以在时间序列分析中取得竞争性的性能。

四 本文工作

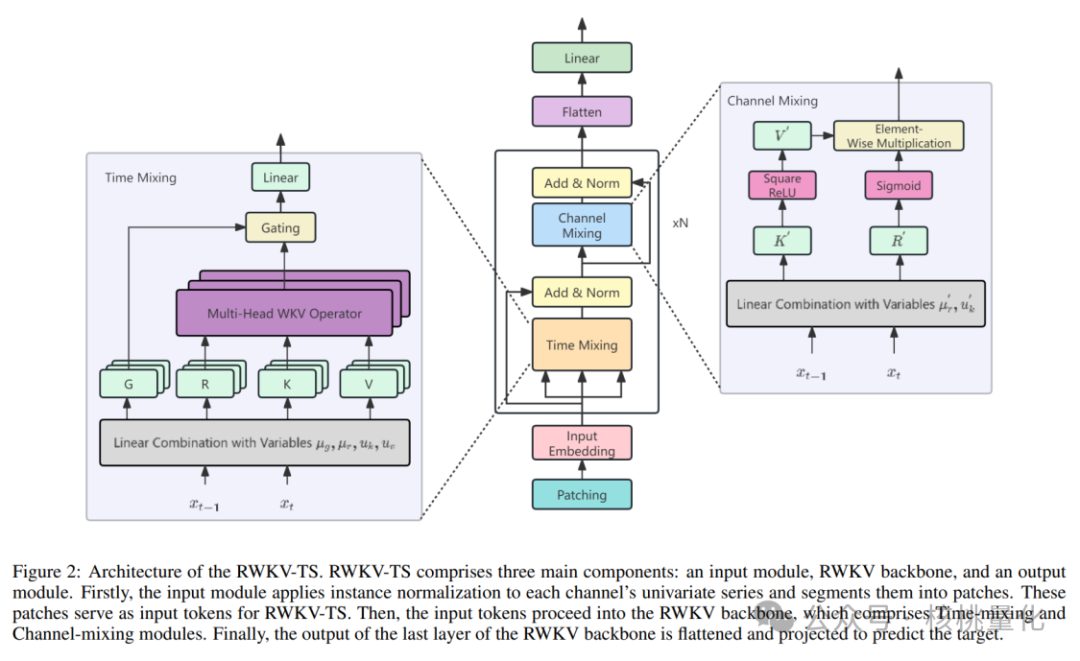

RWKV-TS模型使用RWKV编码器作为核心架构,用于处理多个多变量时间序列的预测问题。

4.1 数据归一化和分块

首先对每个单变量时间序列进行了实例标准化,以减少训练和测试数据之间的分布差异。然后将每个时间序列分成多个片段,可以重叠或不重叠。通过这个分段过程将时间序列数据转换成一系列片段,从而减少了输入的数量。最后通过一个可学习的投影矩阵将这些片段映射为输入标记,供模型使用。这样的处理方式有助于模型更高效地处理时间序列数据,提高预测的准确性。

4.2 RWKV块

RWKV模块是一种神经网络结构,用于处理序列数据。它由多个残差块组成,每个块包含一个时间混合子块和一个通道混合子块。时间混合子块的作用是将当前时间步和上一个时间步的输入进行线性组合,以实现时间混合。这里使用可训练的变量来控制混合的程度,然后通过线性投影将混合结果投影到一个新的空间。通道混合子块的作用是通过强非线性操作将不同通道的特征进行混合。这里也使用可训练的变量来控制混合的程度,并采用一些激活函数来增强非线性。在RWKV模块中,还引入了多头机制,以增强模型的容量。每个头部都有自己的WKV运算符,用于计算头部特定的信息。最后,输出门控制使用一些函数来调整输出向量,以确保输出具有适当的范围和形式。RWKV模块具有并行模式和循环模式。并行模式更适合并行训练和高效计算,而循环模式则将并行模式转化为一种递归的形式,两种模式是完全等效的。RWKV模块通过时间混合、通道混合和多头机制来处理序列数据,并具有并行和循环两种模式。这种结构可以有效地利用过去的信息,提高模型的性能。

4.3 展平计算损失函数

使用一个展平层和一个线性头来获得预测结果yi,使用的损失函数是均方误差(MSE)。

五 实验分析

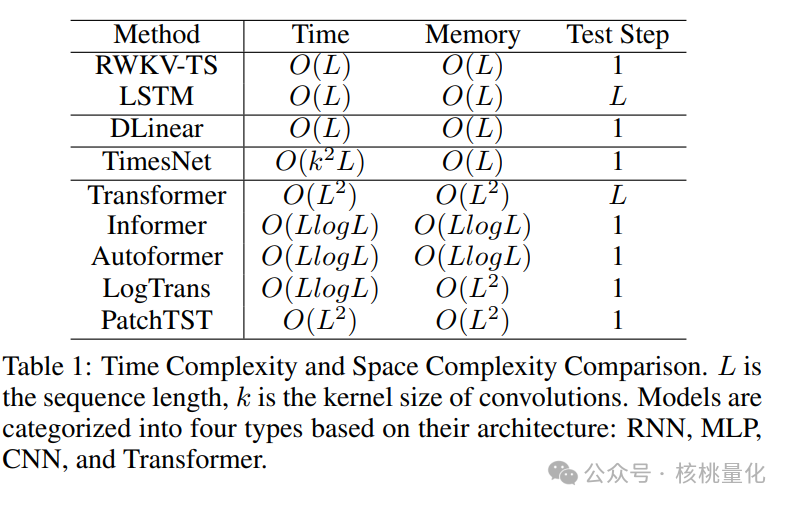

4.1 时间复杂度分析

RWKV-TS是一个线性RNN模型,它的时间和空间复杂度都是O(L),这比基本Transformer的O(L^2)复杂度更好,并且与最高效的DLinear模型相当。与传统RNN模型相比,RWKV-TS具有一些优势。首先,RWKV-TS的线性设计可以进行并行计算,提高计算效率。其次,RWKV-TS能够更好地捕捉长程信息,即使在序列长度较长时仍能保持较强的性能。最后,RWKV-TS采用仅编码器的架构,消除了传统RNN模型中的误差累积问题。

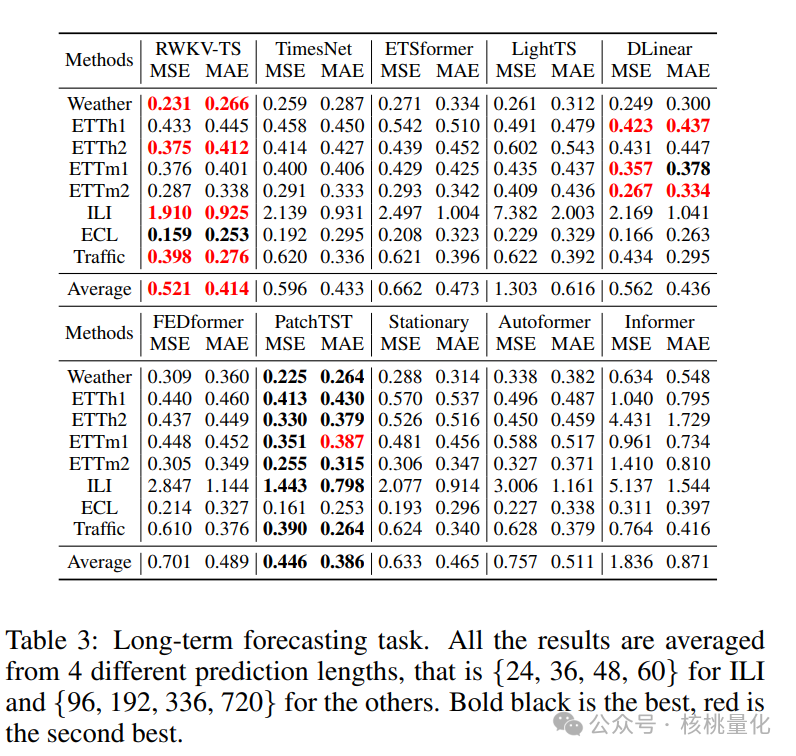

4.2 长序列预测

表3展示了长期预测任务的结果。所有结果都是从4个不同的预测长度平均得出的。黑色粗体表示最好的结果,红色表示第二好的结果。

表3展示了长期预测任务的结果。所有结果都是从4个不同的预测长度平均得出的。黑色粗体表示最好的结果,红色表示第二好的结果。

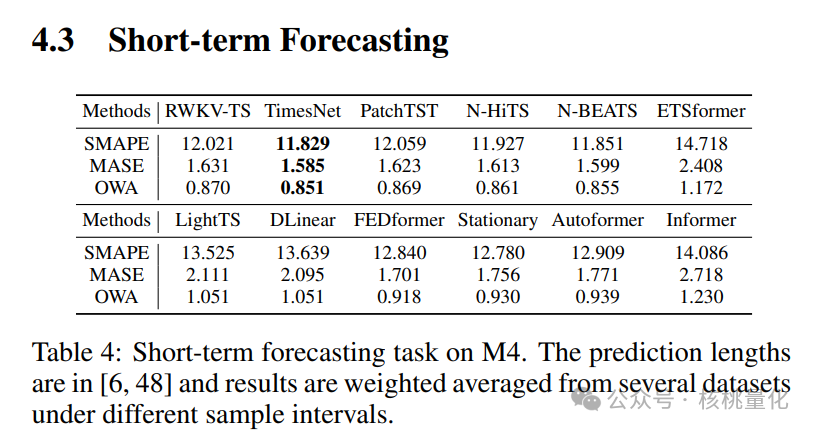

4.3 短序列预测

表4中显示的结果表明,RWKV-TS在性能上超过了一些基于Transformer的模型,如ETSformer、FEDformer、Informer、Autoformer和Nonstationary Transformer。此外,与基于多层感知机(MLP)的模型如DLinear和LightTS相比,RWKV-TS表现出更好的性能。与TimesNet和N-BEATS等最先进模型相比,RWKV-TS的差异也很小。

表4中显示的结果表明,RWKV-TS在性能上超过了一些基于Transformer的模型,如ETSformer、FEDformer、Informer、Autoformer和Nonstationary Transformer。此外,与基于多层感知机(MLP)的模型如DLinear和LightTS相比,RWKV-TS表现出更好的性能。与TimesNet和N-BEATS等最先进模型相比,RWKV-TS的差异也很小。

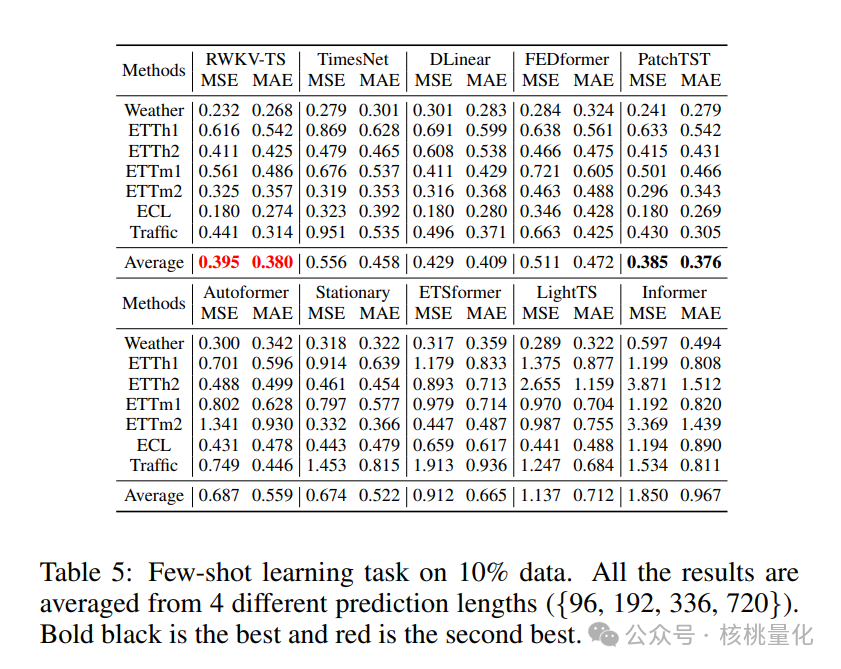

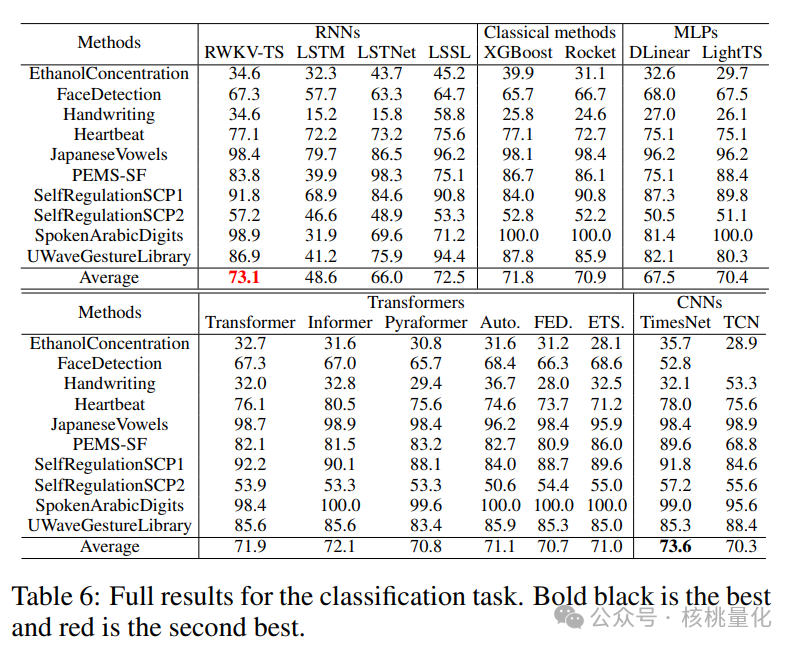

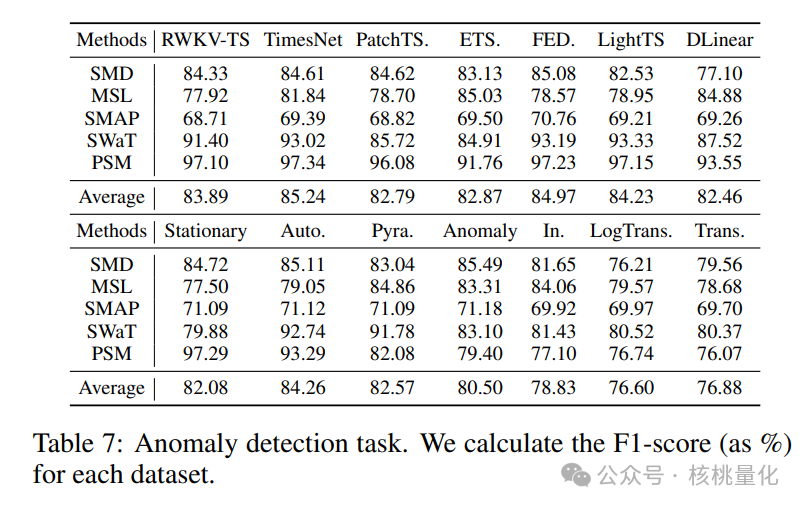

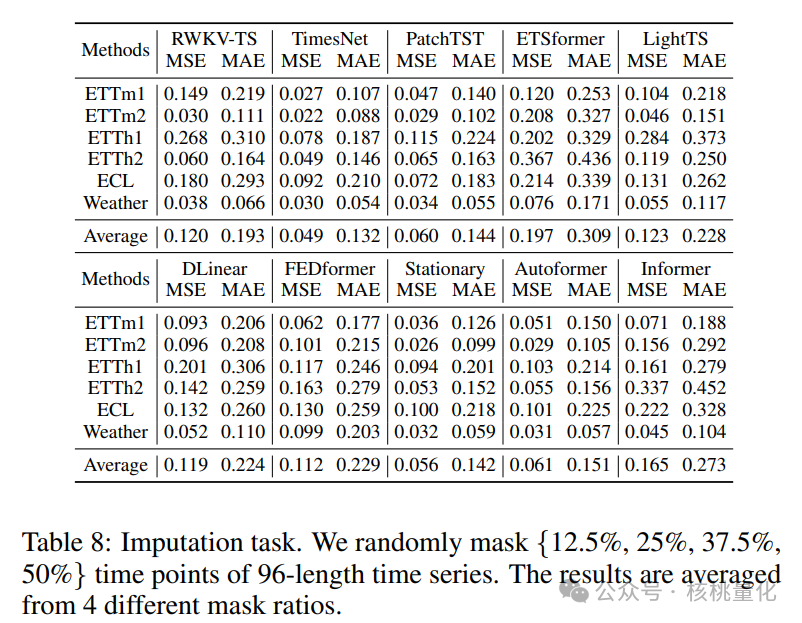

4.4 其它任务

六 总结展望

总的来说,RWKV-TS在多个时间序列任务中表现得很好,与最先进的方法相比不相上下。它在不同任务中相对于PatchTST和TimesNet等模型有不同程度的成功。RWKV-TS最大的优势是它的速度快且占用的内存少,这使得它非常适合在计算和内存资源有限的设备上使用。这意味着我们可以在智能手机、传感器和其他边缘设备上使用RWKV-TS进行时间序列分析和预测。另外,RWKV-TS的成功也回答了一个问题,即循环神经网络是否还适用于时间序列任务。结果显示,循环神经网络仍然具有很好的表现,并且在时间序列分析中非常有用。未来的研究可以进一步改进和创新,提高循环神经网络在处理各种时间数据特征和应用方面的效率和准确性。通过这些努力,我们将能够更好地预测和分析时间序列数据,为各种实际应用提供更准确和可靠的结果。

发布者:股市刺客,转载请注明出处:https://www.95sca.cn/archives/111114

站内所有文章皆来自网络转载或读者投稿,请勿用于商业用途。如有侵权、不妥之处,请联系站长并出示版权证明以便删除。敬请谅解!